田渊栋:

对,大概是这样子。我觉得(裁员)可以说是行业趋势吧,我们不说Meta具体这几次情况,因为我也不方便透露太多,但我觉得行业趋势是如此。

因为AI本身自动化的程度是最高的,比如我们今天有很多人标数据,可能明天模型强了,不需要那么多人标数据了,后天模型更强了,那需要的人就会少。

我以前听说过各种消息,比如说以前on call说我这个模型传到一半挂了,马上打电话过来说:“挂了挂了,马上起来。”然后要修、要调参数,看能不能把它救回来。但是现在因为有很多的自动化的工具,如果整个系统做得很好的话,这种事情也变得会很少。所以这样的话你会相信,各种各样的pipeline(项目流程)都慢慢变得成熟、变成自动化。那你觉得需要很多人吗?也并不需要那么多人。所以我觉得大趋势肯定是做这个事情的人会越来越少,应该是这样的一个状态。

陈茜:

所以你觉得这次裁员不是Meta这一个公司的问题,而是大趋势可能工程师或者是从事AI的人会越来越少。

田渊栋:

应该是这么说,如果说得比较吓人就是,大趋势是总有一天大家都没有工作,或者说没有传统意义上的工作。现在的情况是我受雇一个公司,然后我帮这公司把事情做好,也许以后并不需要这样。

比如说如果我去当CEO,或者我去当一个小公司的领导者,或者我自己去创业的话,现在这些工具拿到手之后,我自己都会觉得我并不需要太多人做这事情。有很多事情可以自动化了,而且自动化的程度非常高。所以也许我本来是需要一个团队,比如说需要几百人、几千人去做一件事情,现在也许不需要那么多人,很多事情可以自动化,可以用agent(智能体)来做。

所以在这种情况下,我觉得总的来说做AI的人可能会越来越少,但是探索用AI来做工具、做其他东西的人会越来越多,大概是这样的一个过程。

陈茜:

你觉得在foundation model(基础模型)研究上面的人会越来越少吗?

田渊栋:

应该说对foundation mode(基础模型)的探索性的研究会越来越多。但是按照我们之前工程上的逻辑,把这个模型做出来、训练出来的这些人会越来越少。因为以后会发现大家都遵循同样的逻辑,把这个模型训练出来,代码都是可以跑的,然后都是能有效果的。那为什么还需要这么多人呢?肯定有更多人会说我们可以做研究,或者是做一些其他探索性的工作,这样的人会越来越多。

陈茜:

做应用的人也会越来越多。

田渊栋:

对,但是这个应用不是那种一般性的应用,很多时候可能会落地到某个具体的垂直领域,或者说用这个东西做一些你现在想做的事情,这样的人应该会越来越多。

陈茜:

但这是中间层的,做执行的那部分人会变少。

田渊栋:

对,因为做执行那些人,首先他们的工作比较重复的,可能很多事情是需要修或者需要处理,但是如果工具的自动化程度越来越高的话,重复性的劳动就会减少。

陈茜:

在这次裁员之前,你本来在FAIR里面在研究什么?

田渊栋:

在裁员之前,我们是今年1月份的时候去GenAI帮忙,这段时间之内,我们大部分时间没有在做研究,而是在做各种比较救火的工作。

陈茜:

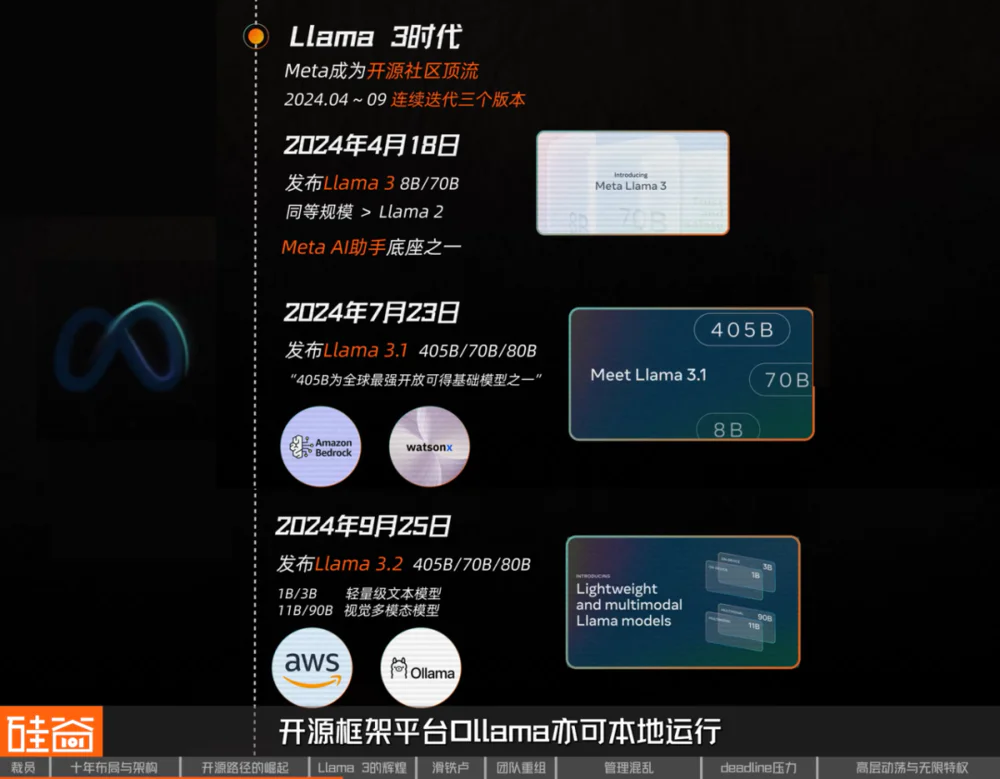

当时就是Llama 4。

田渊栋:

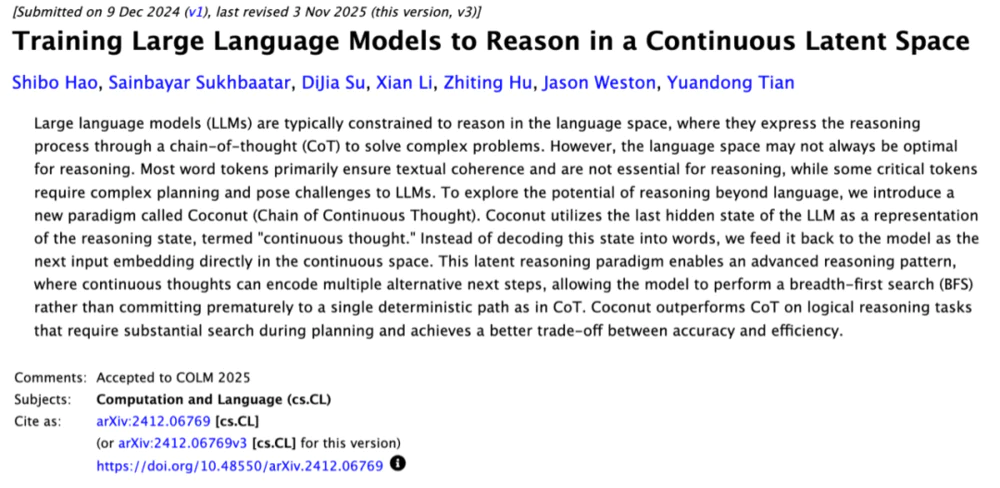

对,当然我个人还是会有一些其他工作,比如说和外面一些其他的一些朋友合作的一些工作,像我们今年四五月份有一篇文章是分析一下我们之前的连续思维链,它的一些理论上的比较厉害的地方。而且这篇文章至少影响力也挺大的,大家会觉得这篇文章给连续思维链Coconut加了一个备注。因为我们在理论上做了更深入的分析,这个分析能够让连续思维链这个思路,让大家觉得可能更有道理,可能会有更多的工作再做下去。

开源仍会继续,模型的“用途”才是核心问题

陈茜:

你可以说一下,开源、闭源接下来的一个发展吗?因为现在有很多外界认为开源在一个大公司的架构里面就不可行了,因为现在前沿模型竞争太激烈了。别人都在闭源,你一个人开源你可能也坚持不下来。你觉得是不是接下来开源模型距离闭源模型的差距越来越远?还有人会做开源吗?

田渊栋:

我觉得硅谷这边还是会有开源的,像我知道的一些公司,比如Reflection AI它们应该就在做开源的模型,它们是有很多的要求、很多的想法想要做这些东西。像之前的OpenAI也做过一些,比如开源的GPT-oss model。所以我觉得开源还是会有的,而且一定会继续发生,像Ai2也在做开源的工作。我觉得接下来更大的问题是:这些模型有什么用?

硅谷101视频节目截屏

陈茜:

你指的是开源的模型有什么用?

田渊栋:

不管开源还是闭源的,因为模型一旦出来之后,这个模型本身大家可以拿来当聊天工具、搜索工具、效率工具,全部都可以,这些东西可能大公司会做。但还有很多的其他的方向,比如这个模型可以拿来做一些科学研发或者说做科学家的工作,或者说做垂直领域的一些工作,这个东西小公司就可以做。

在一定程度之后,这个模型需要有多强能够把这个问题做出来,可能是一个因人而异或者说因问题而异的问题。因为最终发现,我真的需要一个模型在所有方面、在不同领域都很强吗?不一定,可能只在你在意的方向上比较强,这个时候可能就开始分化了。每个人、每个模型可能都有自己的想法,每个公司做这个模型有自己的目的,会有各种各样不同模型做不同的事情。在这种情况下,就可能会有一个不同的策略。

可能有些模型希望开源,因为开源之后,大家用了之后,可以用来做一个社区作为工具、平台,这个时候你开源是很说得通的。比如说我有一个模型,这个模型训练完之后可以调用某种标准工具集,然后我在标准工具集上,我可以再用这个模型去做一个平台让大家用着,那肯定要开源。如果是其他的一些领域,比如说如果这个模型是用来做个性化的搜索或者推荐,这种模型应该说不太愿意开源吧。或者说每个人自己训练一个模型,但是不开源。所以最终看最终的目的是什么,而不是非常泛泛地说:开源和闭源哪个好、哪个不好。最终还是看公司的策略,因为每个公司和每个人其实都是不一样的

陈茜:

所以你觉得就是在SOTA(最前沿模型)上面可能很难有一个开源的模型去跟闭源的模型直接地竞争,但是在很多小的垂类的这种模型上面,还是有非常非常多开源的机会的。

田渊栋:

应该说是这样。

LLM的最大问题:需海量数据

陈茜:

你觉得LLM(大语言模型)是正确的路线吗?

田渊栋:

我觉得LLM是一个很有意思的路线,但我不知道会不会是正确的路线。

陈茜:

这一点你是同意Yann LeCun的吗?

田渊栋:

这个不好说吧。我们大家都是做科学家的,有科学家想法的人都会希望找到一个更好的东西,而不是说我现在就满足于现在的框架,然后我就在上面做到死,肯定不会这样子。所以我总会说有各种各样可能的问题,这些可能的问题怎么样用别的方式来解决,这个是一个很大的问号。

陈茜:

现在大语言模型最大的问题是什么?

田渊栋:

最大的问题就是数据量需要很多。需要很多数据量,那么训练出来的模型质量就肯定很好了,但是肯定没有人那么高效,这个是很大的问题。因为对人来说能学完的样本数非常少,人一生能学到的token的数目可能就只有最多100亿的级别,特别是文本token,这个之前我也在一个演讲分享上面算过,大概是这个数字。但是现在大语言模型训练的数据很轻易地能达到10万亿或者说30万亿这样的大小,中间有1000倍的差距。这1000倍差距。怎么样去用人类的学习能力去弥补?很难弥补,但人就是能学得很好。

在人类历史长河中,有各种各样非常厉害的科学家,他们的思路和想法都是独一无二的,他们那个时候也没有看过那么多书,也没有那么多的数据,但他们就是能够发现一个很有意思的新的定理、新的证明、新的发现或者新的发明。所以对他们来说,他们这些能力从哪来的?大语言模型现在那么多token放进去了之后,有没有达到人的能力?这个其实是现在很大的一个问号。

所以如果是这样的话,其实也许我们现在训练算法并没有达到最优的,有可能有更好的算法、更好的逻辑,或者更好的方式去学习在数据中涌现出来的那些表征,用它来解决问题。也许梯度下降可能并不是一个特别好的方案。可能突然有一天也许不要做梯度下降了,可能别的方法来做,这是我的一个暴论吧。这样的话也许我们整个训练的框架可能要改变。当然这个不一定现在能出现,但是我觉得以后可能是一个可以去实验的比较有意思的方向。

强化学习与高级智能

陈茜:

我看最近业界对强化学习有一点争论,特别是最近Andrej Karpathy接受了一个播客采访,也发表了一些比较负面的一些观点,你是怎么看RL(强化学习)这条路线的?

田渊栋:

对,我一直是做这个方向的,我也是这么觉得的。因为RL(强化学习)本质上来说是个搜索的过程,它的好处就是对于你给定的一些难的问题,让它去搜出来,在搜索的过程中它学到的数据、获得的信息的质量要优于被喂的数据。这个就相当于有一个人是去老师那边听课,他就相当于是Supervised Learning(监督学习)。还有一个人说我不去老师那边听课,我就自己去玩,然后把问题解决了。这两种方式我觉得后者学习出来的能力应该说更本质,解决问题能力更强。所以我觉得RL(强化学习)在这方面应该是优于SFT(监督式微调)的。

你看现在很多的文章,在很多问题上,尤其是推理问题,确实强化学习的能力比SFT(监督式微调)能力要强。你知道你要做强化学习才能让这个模型真的学会推理,如果你做SFT(监督式微调)的话,这个模型可能就记忆了,就是之前的那些推理的过程它并没有产生泛化能力,或者在新的问题上可能泛化能力没有那么强。特别是如果你做了大量的SFT,这个模型的质量就可能会下降。所以这是这两个的区别。

但是强化学习它只是个范式,它不是说是有什么神秘东西在里面。因为它最终的目的还是改变权重,这跟SFT(监督式微调)是一样的,只是说改变权重的方式不太一样。所以其实最终也许存在一个方式可以统一强化学习和SFT(监督式微调)监督式微调吧。因为最终目的都是改变权重,也许我有更好的方法来做这些问题。而强化学习对大家来说,就是一种不同的数据采集的方式而已。它是通过边搜索边采集,然后把这些数据放在一起再去做训练。这样的方式相当于是一个主动学习的方式,跟SFT(监督式微调)的方式是不一样的。

所以我觉得强化学习最大的好处是:它是主动学习的,它能对数据的分布产生很积极的影响,这是它最核心的地方。而不是说它的目标函数不一样,或者说它的训练算法不一样,不是这样子。我觉得最终还是看它采集的数据,它的质量是跟SFT(监督式微调)是不同的。所以它才能够解决一些比较难的问题吧。

Andrej Karpathy之前说的那些东西有些我也觉得挺好的,像关于AGI(通用人工智能)还有10年这样的论断,比如我们是进入了以十年为尺度的时代,而不是进入一个立即就能获得AGI能力的这样一个世界。对于这点我也是相信的。像我自己之前也是用过GPT-5帮我一起做一篇文章,我最近一篇文章其实是我和GPT-5通过self-play(自我博弈)做出来的。相当于我没有任何的学生,我就每天跟GPT-5去对话,我说我有这样的问题要解决,这个问题我们怎么制定研究方法,然后它会给你规划。

但是你会发现如果你自己没有domain knowledge(专业知识),这个规划其实做出来了也是跟大家差不多的,没有什么创新性、没有什么原创性。但是作为研究员就是对这个问题有很深的理解,或者说我知道这个规划或者说它的这个思考的方式是不对的,或者说它的规划有致命的问题。把它指出来跟它说了之后,GPT-5就会在这方面更深入,最终得到一个比较好的结果。所以这种高层的human insights(人类洞察力)、human knowledge(人类知识)和对这个问题的独到见解,这些东西现在的模型是缺的。你必须有这些东西之后才能让这个模型变得更强。所以你要说AGI没有这些东西那就不能称之为AGI。

陈茜:

但模型是不是永远都没有办法获得最顶尖的这种insight(洞察力)?因为insight还是永远都是人来引领的。

田渊栋:

是的,跟以前自动驾驶是一样的:一开始进展非常快,大家会觉得马上就能取代人了,但是越往后走问题越大,为什么呢?因为好的洞察、好的数据越来越少、越来越难找、数据越来越少,那模型就训练不上去。人对于数据的获取能力和人对于数据的深度挖掘能力永远是超过计算机的、超过所有的模型。同样的问题,可能人只要一两个样本就能看到本质,但是计算机或者说现在的大模型的话它可能需要比如说至少几百、上千的样本才能大概感觉到一个轮廓,预训练可能是需要更多的样本。

在这种情况下,如果样本数不够的话,人永远是比现在的大模型要厉害的。特别是对一些小领域的专家,他们甚至自己也没有办法把自己学过的样本吐出来给计算机看,因为这些样本可能在他脑子里,就是他的经验,这些经验很难去量化成一些句子。如果是这样的话,AI就只能永远是跟着人后面走了。

人通过某种比较好的信息处理的方式获得一些洞察,然后灌给计算机、灌给AI,让AI在这个方向上去做得更好,目前是这样的一个状态。

计算量不是全部,Scaling Law是悲观的未来

田渊栋:

我觉得这也是跟我之前的一些论断是比较接近的,因为我以前也是接受过采访,我说:Scaling Law(缩放法则)是一个悲观的未来。因为Scaling Law这个话题本身是一个很奇怪的话题。

如果在以前跟大家说,我加指数级的样本或者指数级的计算能力进去之后,我们的表现会上升而且上升的速度是线性的。我觉得以前的机器学习科学家会觉得这些事情是trivial(微不足道)的。因为不管什么模型,你都可以做出这样的论断:往里面塞数据,然后就会有更好的结果。

但是我觉得我们真正追求的是:什么样的模型能够在这条路线上走得更有效率、更高效、更快,而不是说是满足于这个law(法则)是对的。因为这个law(法则)它给你通向的未来是一个比较悲观的未来,你需要用指数级的样本塞进去才能得到一个比较好的结果。如果是这样的话,总有一天我们地球上所有的资源全部会被用完。地球上所有的能源、所有的电力全部都会被用来训练大模型。在这种情况下,我们是不是还要依赖于这个能力去改变我们这个世界?这个是一个很大的问题

我觉得某个时候可能大家会意识到:计算量不是全部,我们可能需要对模型有更深的理解。而且这改变应该会慢慢发生,这是我的一个想法。

陈茜:

我们就需要一个更高效的方法来发展智能,你觉得需要花很长的时间才会找到这个解法吗?

田渊栋:

我觉得大家也在努力吧,所以应该会花一些时间去做这些事情。至少对于现在来说,大语言模型它的能力是很强的,就算我们这个模型能力现在停滞不前,它对于各行各业的影响也是非常大的。我觉得至少能够自动化很大一部分东西,能让很多人的能力变得更强。我都觉得我加大语言模型,已经远远超过以前的我了。所以这让我觉得,这上面有很多很多空间可以做。所以我有很大的一个感慨就是,我觉得本身是一个新时代的到来了,就算大语言模型的进展不够快的话,未来至少两到三年、三到五年这段时间之内,还有很多机会的。

陈茜:

所以你接下来还是想做前沿研究这一块,还是想去尝试一下application(应用)这一块?

田渊栋:

当然最好是把两个合起来,如果我能够做一个前沿研究并且这个前沿研究是自动化的研究,那就很厉害了。我已经感觉到我的研究范式,可能都会被自动化的pipeline(项目流程)所代替一部分。不一定是Agent(智能体),但是Agent(智能体)肯定是一个很重要的因素。

用Agent(智能体)的话可以帮你做很多事情,比如说你也许不需要自己回邮件,或者说你不需要去管理自己的to-do list(待办事项),或者说你不需要自己去做一些繁琐的事情。这些东西都可以用计算机来帮你做一些自动化,问题是不大的,而且肯定是会发生的。

但是更重要的一个问题是,AI能不能代替人的一些高级活动?人的一些比较高级的思路,需要人的一些重要的insights(洞察)的活动,多大程度上能够让AI帮忙做?有很多很难的一些科学问题,AI能不能把这个事情做成?现在这个还不知道。如果能做成的话,反过来也可以对我的研究产生影响。

研究上来说,也许我会成为一个超级研究员。加了很多AI之后,我一方面能做更好的研究。另一方面,这些工具本身也可以用来造福别的东西。如果是这样的话,可能会很有意思。

还没有评论,来说两句吧...